A Tomsk State University scientist proposes that human beings will reproduce Earth’s biosphere

Gaia, our planet, is alive and we are its spermatozoon, a new study suggests

Il Programma del Seminario e le relazioni

Il ruolo dell’Aidii è quello di favorire la conoscenza dei rischi sia in ambiente di lavoro che in ambiente di vita. È in questo contesto che la sezione Territoriale Aidii Lamus ha ritenuto di portare a conoscenza degli iscritti e di tutti coloro che si interessano di Cem, il contenuto della nuova Direttiva UE grazie al contributo di due dei massimi esperti istituzionali oggi presenti in Italia. I chiarimenti e gli approfondimenti che scaturiranno dal convegno potranno contribuire ad aprire un dibattito che sarà sicuramente utile ai tecnici ed esperti della materia.

Relatori e organizzatori del seminario:

Relatori e Moderatori

Dott. Salvatore Curcuruto

Dirigente del Servizio Agenti Fisici Ispra

Dott.ssa Rosaria Falsaperla

Ricercatore Inail

Dott. Paolo Rossi

Ministero della Salute

Organizzatori

Dott. Pietro Nataletti

Inail – Consiglio Direttivo Aidii

Prof. Giuseppe Romano Spagnoli

Presidente Sezione Territoriale Aidii Lamus

Dott. Pasquale Avino

Sezione Territoriale Aidii Lamus

Dott. Romeo Fusco

Sezione Territoriale Aidii Lamus

Presentazione del Convegno

Giuseppe Romano Spagnoli

Moderatore: Salvatore Curcuruto

La nuova Direttiva Europea 2013/35/UE ed i suoi presupposti protezionistici

Paolo Rossi

Sorgenti di campi elettrici, magnetici ed elettromagnetici nelle attività lavorative. Esposizioni professionali e presentazione di «case studies»

Rosaria Falsaperla

Valutazione del rischio nei luoghi di lavoro: il D.Lgs. 81/2008 e le indicazioni operative delle Regioni

Paolo Rossi

Dispositivi medici impiantabili attivi: valutazione dei rischi e misure di protezione

Rosaria Falsaperla

prova

prova prova

prova

I processi dissipativi nella catena alimentare limitano il cibo per i consumatori

La produttività primaria netta accumulata nei vegetali si rende disponibile per gli animali (organismi eterotrofi) presenti nei differenti livelli delle reti alimentari di ecosistemi terrestri e acquatici. Questi ultimi organismi sono noti come «consumatori». Produttori e consumatori durante il loro ciclo vitale rinnovano cellule e tessuti eliminando rifiuti organici che sono riciclati dagli organismi decompositori. Alla morte di tutti gli esseri viventi, siano essi produttori, consumatori o decompositori, la sostanza organica dei loro «corpi» si rende disponibile ancora per questi ultimi (gli spazzini della natura), soprattutto microrganismi, in grado di decomporla e renderla nuovamente inorganica (per esempio come sali di azoto e fosforo) disponibile per i produttori.

Questi processi di funzionamento della vita negli ecosistemi terrestri e acquatici sono possibili grazie al continuo flusso di energia solare. Però mentre la materia subisce numerose trasformazioni e quindi può essere riciclata e riutilizzata, l’energia nel suo fluire si degrada in quanto soggetta a processi dissipativi. Dalla termodinamica sappiamo che

1) l’energia si conserva, non si può creare né distruggere;

2) ad ogni trasformazione l’energia si degrada.

In altri termini, quando facciamo il pieno di gasolio nella nostra auto il motore consente di trasformare l’energia contenuta nel gasolio in energia di movimento ma soltanto una frazione diventa energia dinamica di movimento mentre frazioni rilevanti si «perdono» nel raffreddamento, attrito, gas di scarico, radiazione del motore etc. Così, non tutta l’energia contenuta nella radiazione solare captata dai sistemi fotosintetici viene trasformata in energia chimica, una parte consistente è perduta in forma di «calore» non utilizzabile. Non esistono macchine perfette con rendimenti del 100% nell’uso dell’energia; frazioni rilevanti si perdono in forma di energia degradata (entropia o disordine termodinamico).

Processi dissipativi che producono entropia si verificano anche nelle reti alimentari nelle quali oltre ai principi della termodinamica intervengono processi di tipo biologico. Pertanto, l’energia chimica contenuta nelle piante ovvero nel primo livello della catena alimentare non può essere completamente trasferita in quella degli animali erbivori ovvero del secondo livello della catena alimentare. Per esempio, un erbivoro nel suo pascolare non consuma totalmente i vegetali di cui si ciba, infatti, le radici o le parti più dure e meno appetibili non vengono mangiate. Eppure anche nelle radici e in tutte gli altri tessuti, siano essi duri o teneri, vi è energia chimica derivante dalla trasformazione di energia solare.

Quindi, questa frazione di energia non viene utilizzata. Inoltre, delle parti consumate non tutto viene assimilato e, quindi, alcuni tessuti vegetali non digeribili vengono eliminati con le feci.

Infine, di quanto è stato assimilato non tutto viene convertito in biomassa; una frazione consistente sarà utilizzata nei differenti processi metabolici che consentono le funzioni vitali dell’erbivoro, a partire dall’energia spesa per mangiare e per il movimento a quella spesa per processi di secrezione, digestione, riproduzione etc. degradandosi nel cosiddetto «calore respiratorio».

Quindi, a fronte di una certa quantità di energia contenuta negli organismi vegetali (produttori) soltanto una parte (circa il 10%) diventerà sostanza organica degli erbivori (consumatori primari). Così di tale sostanza

organica soltanto una frazione (variabile da 1 a 20%) diventerà sostanza organica dei carnivori (consumatori secondari). Infatti, anche per il trasferimento dell’energia dal secondo livello alimentare, quello degli erbivori, al terzo livello, quello dei carnivori valgono le medesime considerazioni energetiche.

Un leone che cattura e uccide una zebra non è in grado di consumarla in tutte le sue parti, tra cui le strutture scheletriche, i denti o gli zoccoli che pure contengono energia chimica. Quindi, questa frazione di energia non viene utilizzata. Così di quello consumato una parte non sarà assimilata e della parte assimilata una frazione rilevante sarà utilizzata per il fabbisogno metabolico del leone (anche per la cattura della zebra) che implica anche in questo caso un degrado come «calore respiratorio». Questo flusso di energia che parte dai vegetali e continua con erbivori pascolanti e carnivori che mangiano erbivori costituisce le catene alimentari del «pascolo».

L’energia non utilizzata e non assimilata può essere ancora recuperata nelle catene alimentari del «detrito» che partono dalla sostanza organica (resti di organismi, rifiuti organici, feci etc.) e vedono l’intervento degli spazzini della natura (detritivori, decompositori) fino ai loro predatori. Tutto il calore respiratorio prodotto in entrambi i tipi di catene alimentari non può essere più recuperato e va ad aggiungersi all’entropia o «disordine» dell’universo. Di fatto, le catene alimentari sono sequenze tra loro interconnesse che costituiscono reti alimentari attraverso le quali fluisce l’energia radiante convertita in sostanza organica.

A fronte di quanto appena riportato, è evidente che passando da un livello alimentare al successivo c’è sempre meno energia (e meno cibo) disponibile per gli organismi negli ecosistemi. Questo fatto incontrovertibile viene rappresentato attraverso piramidi alimentari in cui la quantità (numerica, in biomassa ed energetica) dei vegetali è maggiore di quella degli erbivori, quella di questi ultimi è maggiore di quella dei carnivori e così via fino ai carnivori terminali che sono gli organismi più rari del pianeta. Sempre meno bocche possono essere sfamate passando dal livello dei produttori a quello dei consumatori all’apice di tali piramidi.

Le proteine della carne sono presenti nella dieta dei popoli più ricchi, che possono permettersi il lusso di coltivare terra per produrre alimenti per gli animali domestici e vivere anche come consumatori secondari e terziari, mentre i poveri del mondo mangiano (quando possibile) riso, cereali e patate vivendo soltanto come consumatori primari.

La notevole perdita di energia ad ogni passaggio da un livello alimentare al successivo impone un limite al numero di tali livelli nelle reti trofiche.

L’evoluzione probabilmente non ha prodotto un predatore del leone non tanto perché il leone è così impossibile da uccidere e mangiare (il pianeta ha conosciuto predatori più grossi e terribili del leone) quanto perché ci sarebbe poca energia per sostenere un livello trofico al di sopra di quello del leone. Il fatto che i piccoli del leone possano essere predati dalle iene dipende dalla complessità delle interazioni tra organismi nelle reti trofiche e non significa che la iena occupa stabilmente un livello trofico

al di sopra di quello del leone.

Nel mare le catene alimentari si presentano più lunghe perché sia il consumo sia l’assimilazione soprattutto da parte degli erbivori e, in misura minore, dei carnivori è in genere più efficiente nel trasferire energia da un livello trofico al successivo.

In pratica ad ogni passaggio si perde un po’ meno energia nelle catene alimentari marine. Infatti, i vegetali marini sono più piccoli e teneri e, quindi, più facili da consumare e digerire anche da parte di erbivori a loro volta molto piccoli (zooplancton) mentre quelli terrestri, invece, sono più grandi e con solide strutture di sostegno, spesso molto dure, coriacee e spinose. Comunque, nel mare le reti alimentari sono persino più complesse in quanto la gran parte degli organismi si riproduce attraverso la produzione di uova e larve e, pertanto, molte specie prede mangiano uova e larve dei loro predatori. Inoltre, le cose sono ulteriormente complicate dal fatto che molti organismi marini passano da un livello trofico al successivo durante la loro crescita.

Montagnier, un cammino al servizio della scienza

Ricordo del grande scienziato

Le tappe dei suoi studi e successi. Quella volta di Bella Ciao. L’inutile polemica su vaccini. La scienza, la ricerca e le ragioni del dopo

Il pensiero popolazionale

( Perfezionanda in Diritti Umani, Scuola Superiore Sant’Anna, Pisa, chiara.certoma@sssup.it )

Il problema degli equilibri naturali linneani riemerge nel pensiero popolazionale e nelle ricerche sull’evoluzione che dominano il panorama scientifico del XIX secolo.

Ad elaborare la prima grande teoria evoluzionista è Jean Baptiste Lamarck nella sua Philosophie zoologique del 1809. La causa dei cambiamenti è da individuarsi, a suo parere, non in un intervento miracoloso, quanto in eventi naturali: l’ipotesi evoluzionistica prevede che sia un innato impulso al progresso, presente in tutti i viventi, a provocare cambiamenti sostanziali dall’imperfetto al perfetto, in costante dialettica con l’ambiente (Lamarck, 1976).

Due ambienti interagiscono: quello esterno che presenta le condizioni al contorno che innescano il meccanismo di cambiamento, e quello interno che presenta le risposte adeguate a mutate condizioni d’operatività ambientale.

Gli organismi «incorporano» in un certo senso il loro ambiente esterno nel momento in cui, a causa di mutate condizioni ambientali, sviluppano o inibiscono l’uso di un determinato organo (legge dell’uso e del disuso) e questo carattere che viene acquisito nel corso dell’esistenza può essere trasmesso alla prole (legge dell’ereditarietà dei caratteri acquisiti), permettendo così un migliore adattamento. Sebbene abbia avuto il merito di evidenziare che qualunque cambiamento nel mondo fosse il risultato di una legge naturale e non di un intervento miracoloso, la teoria di Lamarck resta comunque legata all’idea che le variazioni siano sempre e solo prodotte da cause esterne.

Pur non negando l’influenza dell’ambiente come fonte di variabilità ed evoluzione (la seconde parte dell’Origine delle Specie è infatti dedicata alla relazione organismo-ambiente), gli studi di Charles Darwin partono dalla confutazione del finalismo e del determinismo geografico per spiegare la discontinuità e la dispersione delle specie sulla Terra.

Darwin stesso ammette il suo debito intellettuale verso alcuni studiosi dell’epoca: Lyell, padre della geologia, per la sua spiegazione dell’equilibrio come originato da forze antagoniste di carattere materiale; Malthus per l’elaborazione della teoria popolazionale della lotta per l’esistenza1; Lamarck da cui accoglie l’idea dell’esistenza di cause naturali e non divine delle variazioni e il ruolo dell’ambiente come fonte di variabilità ed evoluzione2, ma di cui rifiuta l’idea di una interazione condizionante organismo-ambiente ritenendo che essi interagiscono solo nella selezione.

L’evoluzione è l’effetto dell’accoglienza riservata dall’ambiente a un determinato numero di mutazioni individuali ed è basato sul processo deterministico della selezione. A mutate condizioni ambientali rispondono variazioni individuali casuali che esistono tra gli organismi, generate da mutazioni (eventi rari ma possibili) che originano il processo di adattamento, cioè la risposta di un organismi alla situazione ambientale3.

L’influenza di Darwin nella storia dell’ecologia è, però, un argomento controverso. In ogni caso il termine ecologia viene coniato nel 1866 proprio da un: Ernst Haeckel.

Con il termine «ecologia» Haeckel intende la scienza dei rapporti tra gli organismi e il mondo esterno, nel quale si possono riconoscere i fattori della lotta per l’esistenza. Fra le condizioni di esistenza di natura inorganica alle quali un organismo deve sottomettersi, rientrano in primo luogo le caratteristiche fisiche e chimiche dell’habitat, il clima, i caratteri chimici, la qualità dell’acqua, la natura del suolo, etc.

1 Secondo tale teoria gli individui entrano in competizione per le risorse dal momento che si verifica sempre un aumento geometrico della popolazione ma una progressione geometrica delle risorse.

2 Scrive Darwin:

Lamarck per primo rese all’umanità il grande servigio di richiamare l’attenzione sulla possibilità che qualunque cambiamento nel mondo […] fosse risultato di una legge e non di un intervento miracoloso (Darwin, 1967, p. 68).

Ma, nonostante riconosca questo suo grande merito, Darwin resta scettico verso l’abitudine dei naturalisti di considerare

Sempre le condizioni esterne, ad esempio il clima, il cibo, etc. come le sole possibili cause di variazione […]. È assurdo, ad esempio, attribuire alle sole condizioni esterne la struttura del picchio […] così adatta a catturar gli insetti sotto la corteccia degli alberi (Darwin, 1967, p. 79)

3 Darwin non nega l’influenza dell’ambiente come fonte di variabilità ed evoluzione («sono convinto che la selezione naturale è stata il più importante, ma non l’unico mezzo di modificazione» (Darwin, 1967, p. 81)), a far ciò è August Weismann, padre del neodarwinismo secondo il quale la linea germinale influenza il soma (della generazione successiva) ma il soma non ha effetto sulla linea germinale. La lezione di Weismann, dunque del Neodarwinismo di cui è il maggiore esponente, influenzerà pesantemente la lettura di Darwin che ancora oggi viene data soprattutto nell’ambito della genetica e della biologia molecolare. Si veda in merito l’attuale dibatto tra «ultradarwiniani» e «naturalisti» (Eldredge, 1999).

Effetti del terremoto sulle strutture

Gli edifici crollano sotto l’azione del terremoto a causa della loro massa che, per il principio di inerzia, tende e rimanere ferma mentre il terreno sottostante si sposta. Ciò fa insorgere all’interno della struttura tensioni e deformazioni che possono causarne anche il collasso. Se disponessimo di un materiale da costruzione ultraleggero (come una specie di «superpolistirolo») potremmo realizzare edifici perfettamente antisismici. In effetti, in Giappone la case venivano costruite in legno con pareti di carta proprio per la leggerezza di tali materiali. In mancanza di un materiale ultraleggero, dobbiamo necessariamente usare materiali in grado di resistere alle sollecitazioni che nascono nella struttura durante il terremoto a causa della loro stessa massa.

A questo punto, è utile definire il concetto di frequenza naturale. Ogni struttura, se eccitata e poi lasciata libera, oscilla naturalmente compiendo un determinato numero di cicli al secondo, che costituiscono appunto la sua frequenza naturale fn, che risulta essere proporzionale alla rigidezza della struttura (K) ed inversamente proporzionale alla sua massa (m), secondo la relazione:

fn = (1/2Ξ)*(K/m)

Gli edifici hanno in genere frequenze naturali di pochi Hz (l’Hertz è l’unità di misura della frequenza e corrisponde a cicli al secondo). Osservando la (Fig. 1) è facile vedere che strutture leggere e/o rigide sono caratterizzate da alte frequenze, mentre strutture pesanti e/o flessibili avranno basse frequenze naturali. Questo significa che un grattacielo (alto e flessibile) oscilla più lentamente di una casa in mattoni (tozza e rigida). Quando una struttura viene eccitata alla propria frequenza naturale si ottiene la massima risposta in termini di deformazioni e sforzi.

I terremoti sono in genere composti da serie di onde sismiche che spaziano dalle frequenze più basse fino a quelle più alte, con una distribuzione energetica tutt’altro che uniforme, rappresentata schematicamente in Figura 1. Purtroppo i terremoti sono in genere più energetici proprio nell’intervallo di frequenze dove cadono normalmente quelle degli edifici. Per uscire da questa zona pericolosa, normalmente si aumenta la frequenza naturale della struttura cercando di alleggerirla e/o di irrobustirla (come detto in precedenza). Questo è quello che fa l’ingegneria antisismica convenzionale.

Osservando il grafico di Figura 1 si vede che, nella zona delle alte frequenze, la curva raggiunge un valore praticamente costante e non si abbassa più. Questo significa che una struttura, per quanto rigida o leggera, non può sottrarsi ad un certo livello di terremoto. Al contrario, nella zona delle basse frequenze si osserva che la curva di Figura 1 parte da zero. Ciò significa che in tale intervallo di frequenze il terremoto non ha in pratica energia perché il corrispondente moto sismico avviene a velocità troppo basse. Durante il recente terremoto che ha colpito il Giappone, l’intera isola di Honshu si è spostata di diversi metri; però, questo enorme spostamento è avvenuto a velocità molto bassa e non ha causato danni alle strutture.

Purtroppo soltanto i grattacieli più alti hanno frequenze così basse da non risentire (o quasi) del terremoto. Ovviamente, non possiamo costruire solo grattacieli. Nel prossimo paragrafo vedremo come sia possibile far assumere ad un edificio normale una frequenza così bassa.

Figura 1. Rappresentazione schematica del contenuto energetico di un terremoto in funzione della frequenza. È evidente che a basse frequenze il terremoto ha poca energie. Strutture aventi frequenze proprie basse sono pertanto «naturalmente» protetti.

L’isolamento sismico consiste nell’inserimento, fra la fondazione e la base dell’edificio, di opportuni dispositivi, detti appunto isolatori sismici, in grado di reggere il perso della struttura e di consentire contemporaneamente spostamenti laterali. In questo modo la componente orizzontale del terremoto (che è la più pericolosa ai fini dell’integrità strutturale) viene filtrata, attutita ed ammortizzata. In pratica, l’edificio assume una frequenza naturale molto bassa (tipicamente 0,5 Hz) e, durante il terremoto, si muove lentamente al di sopra del sistema di isolamento sismico, offrendo protezione non solo alla struttura portante, ma anche ai contenuti che, a volte, hanno un valore superiore a quello dell’edificio stesso (basti pensare a ospedali, musei, banche dati). Al termine di un terremoto, un edificio sismicamente isolato è perfettamente agibile. Non c’è pertanto bisogno di evacuare gli abitanti (e trovare loro una problematica sistemazione provvisoria), né di ricostruire. I vantaggi economici che ne derivano superano di gran lunga i costi di applicazione di questa tecnologia, che sono in genere inferiori al 10% del costo dell’edificio al grezzo. Purtroppo, per far questo, occorre una lungimiranza che questo Paese non ha ancora dimostrato di avere. Ci sono comunque, a onor del vero, segnali incoraggianti.

Gli isolatori sismici, oltre a garantire la funzione di appoggio, devono avere: a) una bassa rigidezza orizzontale; c) una buona capacità dissipativa; d) una buona capacità di ricentraggio per limitare gli spostamenti durante il terremoto e lo spostamento residuo al termine dell’evento. Le ultime due proprietà possono essere affidate anche a dispositivi ausiliari.

Le più diffuse tipologie di isolatori sono due: gli isolatori elastomerici armati (con o senza nucleo centrale in piombo) e gli isolatori a scorrimento (a superficie piana o curva, quest’ultimi anche conosciuti come «pendoli scorrevoli»).

L’isolatore in gomma armata con piastre d’acciaio (Figura 2) è certamente il più diffuso. La gomma, che può essere naturale o (più raramente) sintetica, fornisce la flessibilità e la forza elastica di ricentraggio. Aggiungendo particolari additivi, la gomma può assumere anche discrete capacità dissipative. In zone ad elevata sismicità, dove occorre una notevole capacità dissipativa per limitare gli spostamenti della struttura isolata, al centro dell’isolatore può essere disposto un nucleo di piombo.

Figura 2. Isolatore elastomerico in gomma armata con piastre d’acciaio. Le piastre conferiscono all’isolatore un’alta rigidezza verticale, che consente di reggere il peso della struttura per tutta la vita utile dell’edificio.

Gli isolatori a scorrimento a superficie piana (comunemente chiamati «slitte») vengono in genere usati in parallelo agli isolatori elastomerici o ad altri dispositivi elastici in grado di fornire la forza di ricentraggio (che essi non possiedono). Tale forza di ricentraggio è invece presente nei cosiddetti pendoli a scorrimento (Figura 3) che recentemente sono stati largamente utilizzati in Abruzzo.

Figura 3. Isolatore a scorrimento a superficie curva (pendolo scorrevole). In questi dispositivi la superficie di scorrimento ha in genere un raggio di curvatura di qualche metro, che consente alla struttura di «ricentrarsi», di tornare cioè nella posizione iniziale al termine del terremoto.

La Natura. Un bagaglio di idee per la tecnologia

La bionica è la scienza che studia i principi dell’organizzazione degli esseri viventi per la loro applicazione alle necessità tecniche. Essa è l’argomento chiave della giornata «Tecnology day: Bionica – imparare dalla Natura» che si terrà il 24 luglio a Bolzano

«Osserva in profondità, nel profondo della natura, solo così potrai comprendere meglio ogni cosa»(A. Einstein)

La «scienza che studia le analogie strutturali e funzionali esistenti fra organismi viventi e dispositivi elettronici, allo scopo di costruire apparecchiature che svolgono funzioni tipiche degi organismi viventi».

Essa prende spunto dalle «invenzioni della Natura» e le applica alle tecnologie moderne.

Il termine «Bionica» è stato coniato nel 1958 dal comandante Jack Steel, della Us Air Force che la definì: «analisi del funzionamento reale dei sistemi vivi e una volta capiti i meccanismi materializzarli negli apparati» definizione che continua a essere valida anche ai nostri giorni.

Il termine ha due diverse spiegazioni:

– deriva dall’unione di biologia ed elettronica.

– deriva dal lemma greco «????» (pronunciato «bion»), che significa «unità di vita», e il suffisso -ic, che significa «come», «simile a» o «nella maniera di», da cui si ottiene «come la vita».

Il primo ricercatore bionico fu sicuramente Leonardo da Vinci, che applicò i suoi studi sull’uomo a praticamente tutti i suoi progetti, iniziando dallo studio dell’anatomia umana e dallo studio dell’anatomia di insetti e uccelli, che lo portarono all’ideazione delle macchine volanti, come l’ornitoptero, un dispositivo volante con ali battenti, realizzato a partire proprio da uno studio anatomico degli uccelli.

Le tecnologie attuali sempre più attingono alle idee e a soluzioni provenienti dalla «geniale» Natura, che nel corso di milioni di anni ha sperimentato i suoi prototipi grazie ai delicati meccanismi dell’evoluzione e della selezione naturale perfezionando strutture e processi sempre più adatti alla sopravvivenza degli organismi vegetali e animali.

La caratteristica importante della bionica, è la sua interdisciplinarietà, che non si riduce mai alla semplice imitazione di modelli biologici ma va sempre oltre basta citare la biomeccanica, la biomimetica, la biotecnologia, i biomateriali, il biostile tutti evoluzioni della stessa bionica.

Nel corso degli anni la bionica da moda è diventata una vera e propria scienza e materia di studio in importanti isituti prima nei corsi del Mit (Massachusetts institute of technology) di Boston e ora anche in università italiane e del resto del mondo.

La natura in questi miliardi di anni è riuscita ad elaborare strategie sofisticate che convivono in un equilibrio sottile ma vincente sotto molti aspetti.

Essa funziona senza creare rifiuti perché tutto ciò che viene prodotto è sempre materia prima di altri processi, in un regime di interdipendenza tra diversi organismi ed elementi naturali come avviene per esempio nel ciclo dell’acqua, che da fiumi e laghi si sposta alle nuvole, tornando a terra con le precipitazioni; ma gli esempi di come tutto sia riciclato in natura sono infiniti. Negli ecosistemi non servono discariche o inceneritori e tutto ciò che viene scartato dagli animali o dalle piante diviene alimento per altri esseri viventi, in un ciclo senza fine.

Da questa perfezione l’uomo può e deve imparare visto lo stato di emergenza in cui viviamo. Ci troviamo in un periodo di grandi sprechi, energetici e non solo, e di grande necessità di riciclare per alleviare le emergenze rifiuti. É necessario investire soldi in ricerche destinate a soluzioni sostenibili. Solo escogitando nuove tecnologie prese dal laboratorio «Natura» potremmo ritornare in armonia con il nostro Pianeta.

La disciplina che fonda le sue radici nella bionica e che studia non solo le strutture e i processi del mondo animale e vegetale ma anche le strategie e le logiche proprie dei viventi e se ne serve come fonte di ispirazione per creare nuove soluzioni tecnologiche che migliorano le attività umane è la biomimetica.

L’interdisciplinarietà di questa scienza ha insegnato a botanici, zoologi e ingegneri a dialogare maggiormente tra loro per trovare insieme delle soluzioni ai problemi attuali e non.

«La natura è in grado di offrire una quantità infinita di soluzioni»

Sia che si tratti di elementi per strutture edilizie come i favi delle api, sia nelle superfici funzionali come i fiori di loto autopulenti, la natura è in grado di offrire una quantità infinita di soluzioni, che possono essere d’ispirazione per le tecnologie più moderne come:

– I pesci per le barche e i sottomarini.

– La velocità e la leggerezza degli uccelli sono fonte di ispirazione per l’aeronautica, infatti la forma delle ali dei più moderni aerei sono una copia dalle ali dei condor.

– Uno dei primi esempi di biomimetica è il velcro, ispirato dai fiori della bardana e sviluppato sulla base dei suoi caratteristici uncini, è un brevetto fondamentale che oggi permette di guadagnare cifre astronomiche.

– per progettare la plancia traspirante delle autovetture è stata studiata la pelle della rana.

L’osservazione della struttura e del comportamento degli insetti ha fornito ai ricercatori mille spunti diversi, applicabili alle realtà più disparate.

– Le ultime generazioni di robot in grado di muoversi agilmente su superfici anche accidentate, nascono copiando le zampette di alcuni artropodi in grado di spostarsi raggiungendo una velocità superiore a cinquanta volte la lunghezza del loro corpo per secondo senza perder l’equilibrio.

– La struttura dei termitai, dotati al loro interno di condizioni di umidità e temperatura costante, ha invece aiutato gli architetti a progettare i condotti di aerazione di edifici innovativi (come l’Estgate in Zimbawe), che consumano solo il 10% dell’energia necessaria al condizionamento di edifici tradizionali.

– Il comportamento delle formiche durante la ricerca del cibo ha permesso di formulare algoritmi in grado aiutare a scegliere i percorsi ottimali per veicoli o persone, da applicare allo studio della logistica o del traffico, mentre il comportamento sociale degli insetti è alla base della cosiddetta robotica collaborativa.

– Il meccanismo di termoregolazione dei pinguini ha portato a nuovi tessuti per l’abbigliamento spostivo invernale.

– la resistenza all’impatto delle ossa ha ispirato la creazione di nuovi caschi ed elmetti di protezione.

– Il funzionamento dei muscoli ha portato all’ideazioni di nuove tecniche per la costruzione di fondazioni per edifici antisismici.

-Il meccanismo di apertura e chiusura delle pigne ha ispirato la creazione di nuovi tessuti per a diversi gradi di traspirabilità per abbigliamento.

– Le proprietà meccaniche del legno ha portato alla creazione di nuovi giubotti antiproiettile.

– Il colore iridescente delle ali di una specie di farfalla sudamericana ha ispirato il tessuto prodotto da un’azienda giapponese, la cui tinta non è dovuta alla presenza di un colore, ma a spessore e angolazione dei vari strati sintetici di cui il tessuto è composto.

– Sempre più avanzati sono poi gli studi sul segreto della resistenza delle tele di ragno. Sono il modello ispiratore per funi e cavi sottili sospesi che devono sopportare tensioni enormi.

– Anche i costumi da bagno a basso attrito, che abbiamo visto in azione durante le recenti Olimpiadi sono frutto della biomimetica. I tessuti che li compongono sono dotati di piccole scanalature che mimano le piccole squame della pelle dello squalo producendo un vantaggio idrodinamico.

– La struttura delle penne del gufo, che permettono al predatore di catturare la preda planando velocemente e silenziosamente, hanno ispirato la realizzazione di nuovi pantografi

– La forma il becco del martin pescatore ha permesso alla compagnia ferroviaria giapponese di progettare la locomotiva di un treno così aerodinamica da viaggiare a più di 300 km/h con un risparmio di energia pari al 15% rispetto a una locomotiva tradizionale.

– Dalle tecniche adottate dagli organismi acquatici, un’azienda australiana ha sviluppato recentemente una serie di tecnologie. Ha progettato un impianto energetico costituito da alghe meccaniche altamente tecnologiche, in grado di immagazzinare l’energia delle correnti marine. Il dispositivo è nato osservando e simulando la struttura delle piante acquatiche che non hanno un fusto. Le loro foglie sono spesso dotate di piccole vescicole contenenti aria così, pur essendo ancorate al suolo, non restano appiattite sui fondali marini. Le vescicole galleggianti permettono alle foglie di fluttuare mosse dalle correnti e gli impianti creati dall’azienda, sfruttando lo stesso principio, sono in grado di produrre energia elettrica rinnovabile ed ecologica.

– L’efficienza e la funzionalità delle forme è alla base anche degli studi condotti dall’università americana di West. I ricercatori hanno approfondito lo studio delle protuberanze irregolari sul bordo delle pinne delle megattere e hanno progettato nuove pale per turbine eoliche più efficienti e silenziose di quelle tradizionali.

– Il sistema di termoregolazione delle pellicce degli orsi offere un ottima soluzione per l’isolamento termico degli edifici. Infatti è stato ricavato un certificato green per la costruzione di abitazioni «Casaclima» diffuse molto a Bolzano. è un metodo di certificazione energetica degli edifici. Si avvale di un calcolo convenzionale codificato. È stato ideato da Norbert Lantschner. Questa certificazione aiuta i professionisti a valutare i propri edifici in fase di progettazione stabilendo a quale classe energetica dovranno appartenere una volta realizzati.

– Un noto esempio di arto bionico è quello dell’atleta Pistorius, che tanto ha fatto discutere nelle passate Olimpiadi. L’atleta «bionico» con le sue gambe artificiali ha messo in crisi il mondo dei «normodotati», Il bioingegnere che ha costruito le protesi di Pistorius, è Hugh Herr, del Mit (Massachusetts institute of technology di Boston) un grande sostenitore degli studi sulla bionica.

Da questo incomparabile bagaglio di esperienze si può ottenere il massimo beneficio a livello imprenditoriale.

Che c’entra il Dl alluvione con la semplificazione per per rigassificatori?

Greenpeace Italia: «Assurda la decisione del governo di inserire nel dl alluvione la semplificazione in materia di rigassificatori»

Caratteristiche tecniche di BoxXland

La struttura portante interna è costituita da profilati in acciaio zincato mentre il tamponamento interno è realizzato con pannelli sandwich termoisolanti.

All’interno del container sono posizionati n. 2 rack di coltivazione, ovvero 2 linee per la produzione fuori suolo su 4 piani sovrapposti (16 bancali) per un totale di 62,40 m2 di area coltivabile.

Alla base di ogni rack è installato un serbatoio che serve come buffer idrico per i cicli di irrigazione di ogni colonna di coltivazione e da intermediario all’impianto di fertirrigazione.

La coltivazione della Vertical Farm è completamente gestita, a livello di luce, da un impianto di illuminazione artificiale integrale con lampade a Led che vengono fissate sotto ogni bancale.

L’impianto di climatizzazione è composto da pompe di circolazione, valvole miscelatrici ed aerotermi dimensionati per ottimizzare temperatura, umidità e concentrazione di CO2 all’interno della Vertical farm per tutto il ciclo di coltivazione, per 365 giorni l’anno, in un ambiente isolato, coibentato, attraverso forzatura e raffrescamento dell’aria.

L’impianto di fertirrigazione, completamente computerizzato, provvede a controllare e integrare le soluzioni da mandare in circolo ad ogni ciclo nutritivo.

Il costo del container da 40” è di 95.000 € +Iva.

La denuncia di Ispra

Ispra fornirà tutta la collaborazione tecnico scientifica alle autorità per le indagini in corso

L’isolamento sismico

( Enea, Centro ricerche, Casaccia )

L’idea dell’isolamento sismico nasce dall’analisi dello spettro di risposta ai terremoti in termini di accelerazione, riportato in figura 2. In genere, esso presenta forti amplificazioni nel campo dei bassi periodi di oscillazione (T

Fig. 2 ? Spettro di risposta elastico in accelerazione (linea continua) e spostamento (linea tratteggiata)

L’isolamento sismico alla base, aumentando consistentemente il periodo d’oscillazione mediante l’inserimento di particolari dispositivi tra la struttura in elevazione e la fondazione, determina il «disaccoppiamento» del moto della costruzione rispetto a quello del terreno: mentre questo si muove con accelerazioni anche elevate, invertendo molte volte il verso del moto durante l’evento sismico, la struttura al di sopra del sistema di isolamento oscilla lentamente con spostamenti relativi tra i vari piani trascurabili, essendo gli spostamenti assoluti molto ampi ma pressoché costanti lungo l’altezza dell’edificio. Le sollecitazioni, come può dedursi dai valori spettrali, sono ridotte del 70-80%, o anche più, ed è possibili progettare le strutture in campo elastico, ossia in modo che non subiscano danni nemmeno in occasione di eventi sismici violenti. Gli spostamenti assoluti, come detto, aumentano considerevolmente: gli isolatori devono essere in grado di sopportare questi spostamenti e la costruzione deve essere libera di spostarsi lateralmente, grazie ad opportuni giunti.

In realtà il concetto di isolamento sismico trova origini molto lontane. Nella «Naturalis Historia» Plinio Il Vecchio agli inizi del I secolo d.C. scriveva: «Grecae magnificentiae vera admiratio extat tempium Ephesiae Dianae CXX annis factum a tota Asia. In solo id palustri fecere, ne terrae motum sentiret aut hiatus timeret, rursus ne in lubrico atque instabili fondamenta tantae molis locarentur, calcatis ea substravere carbonibus, dein velleribus lanae». Alla base della costruzione del tempio di Diana ad Efeso (eretto nel VI secolo a.C. e riedificato nel 416 a.C. dopo un incendio) c’è l’intuizione di disaccoppiare il moto della struttura da quello del terreno utilizzando uno strato di frammenti di carboni costipati e uno di velli di lana. Veniva realizzato così un isolamento che, in caso di scosse telluriche, avrebbe consentito alla struttura di scorrere sul sito di fondazione preservandola dal crollo.

Secondo gli scritti di Diogene Laerzio (II, 103) nel III secolo d.C. l’idea di progettare il sito di base del tempio di Artemide con strati alterni di carbone e velli di lana fu suggerito da un grande architetto dell’epoca, Theodoros di Samo, che applicò la stessa tecnica per l’edificazione del tempio Heraion (VI secolo a.C.). Questa procedura era ben nota ed utilizzata dagli architetti greci come dimostrano i vari reperti archeologici, contemporanei alla costruzione del tempio di Diana, ad esempio il

tempio di Atena ad Ilion (III secolo a.C.), in cui l’isolamento sismico era realizzato con strati di sabbia e pietrisco sui quali poggiavano le strutture in elevazione. Anche le colonie greche sul Mar Nero furono influenzate da questa tecnica per la posa delle fondazioni; gli scavi realizzati hanno portato alla luce strati di cenere mista a carbone e loess.

Alcuni studiosi ritengono che le fondazioni delle mura di Troia, la cui costruzione risale a 3.500 anni fa, furono progettate con criteri antisismici. Gli scavi effettuati intorno agli anni Trenta hanno portato alla luce uno strato di terra compatta lasciato volutamente tra la roccia e il piano di posa: un cuscino di terra, come per primo lo definì Blegen, l’archeologo autore di tale teoria (Carpani, 2002).

Notizie frammentarie riguardanti arcaiche tecniche di isolamento sismico ci giungono anche dall’ultima delle grandi colonie campane fondata intorno al 700 a.C, Poseidonia, dal nome del dio greco del mare Poseidon; Paestum, come fu ribattezzata dai romani nel 273 a.C, è dominata dalla presenza di tre templi dorici le cui fondazioni sono separate dalla roccia di base da uno strato di sabbia (Figura 3).

Figura 3 ? Il Tempio di Nettuno a Paestum

In Cina, nella provincia dello Shanxi, un monastero costruito nel 313 su strati di terreno sabbioso riuscì a resistere a numerosi terremoti di cui uno di magnitudo 8,2; da questo terremoto uscì indenne anche un tempio eretto nello stesso territorio nel 1056. È inoltre sorprendente vedere come le pagode con i loro pesantissimi tetti in legno siano riuscite a sopravvivere a diversi terremoti per oltre mille anni. Il motivo può essere ricercato nelle tecniche costruttive dell’epoca: questo tipo di struttura veniva semplicemente poggiata sul terreno senza creare un vero e proprio vincolo di continuità con esso, realizzando così un debole accoppiamento suolo-struttura che permetteva alla costruzione di scorrere in caso di terremoto senza riportare danni rilevanti.

La tecnica dell’isolamento sismico era ben conosciuta anche alla popolazione Inca del Perù. Le maestose mura della città di Cuzco, affascinante esempio della capacità architettonica e strutturale di questa civiltà nata agli albori del XIII secolo, e altre costruzioni dell’epoca sono uscite indenni dai violenti terremoti verificatisi nel corso dei secoli, mentre successive edificazioni di origine spagnola hanno riportato danni ingenti. Gli Inca, oltre ad avere ben chiari il concetto di regolarità geometrica e la necessità di incastrare tra di loro i blocchi di pietra, sempre di notevoli dimensioni (6 ? 9 metri di lunghezza per 5 di profondità), realizzavano le fondazioni con uno strato isolante di sabbia e sassi, profondo all’incirca un metro, che permetteva alla struttura di assestarsi senza subire danni. Con lo stesso criterio sono stati costruiti ad Arequipa, circa 1.000 km a sud di Lima, intorno al XVI secolo, diversi edifici, tra cui il suggestivo monastero di Santa Catailina, che ha sopportato devastanti terremoti.

L’idea del disaccoppiamento suolo-struttura, come sistema di protezione sismica, torna a galla

alla fine del XIX secolo. Nel 1870 Touvaillon progettò un edificio residenziale, inserendo tra la sovrastruttura dalla fondazione dei rulli, che potevano scorrere in apposite nicchie di geometria ellittica al fine di garantire il ritorno alla posizione iniziale in caso di rotolamento del rullo.

L’inglese John Milne, docente di Ingegneria Mineraria presso l’Università di Tokyo, noto come «il padre della moderna sismologia», essendo l’inventore del sismografo, descrisse, in una pubblicazione sul British Association for the Advancement of Science del 1885, un esperimento condotto su una costruzione dotata di un particolare dispositivo di isolamento sismico da lui inventato. La struttura era costruita su pilastri alla sommità dei quali v’erano travi in ghisa aventi funzione di cordolo, nelle quali erano ricavate apposite nicchie concave che alloggiavano sfere libere di muoversi. Sopra le sfere e inferiormente alla sovrastruttura erano altre travi in ghisa simili a quelle sistemate inferiormente. Le dimensione delle sfere furono modificate più volte per migliorare la risposta dinamica e le prestazioni nei confronti delle sollecitazioni dovute al vento.

Nel 1906 Jacob Bechtold propose una struttura sismoresistente, consistente in una piastra indeformabile, capace di sostenere l’edificio, semplicemente appoggiata su corpi sferici di materiale rigido.

Nel 1909 il medico inglese Jhoannes Avetican Calantarientes previde l’interposizione di uno strato di talco fra la struttura e le sue fondazioni capace di disaccoppiare il moto della struttura da quello del suolo. Con tale tecnica ottenne una cospicua riduzione delle accelerazioni pur se con rilevanti spostamenti. Previde anche particolari dispositivi che consentivano l’elongazione delle condotte in caso di importanti spostamenti, limitando così il rischio conseguente alla lacerazione di pericolose tubature quali quelle del gas o di altri liquidi nocivi e appositi dispositivi che ne assicurassero la rigidezza nei confronti di azioni di modesta entità di natura sismica o semplicemente dovute al vento.

In Italia, intanto, il famoso terremoto del 1908 distrusse Messina e Reggio Calabria, con ingente tributo in vite umane e spinse il governo italiano a ricercare una soluzione per preservare i tipici edifici in muratura del meridione da futuri eventi. Fu anche presa in considerazione l’ipotesi di dotare le costruzioni di dispositivi d’isolamento sismico, ricalcando i metodi utilizzati in tempi antichi, ovvero strati di sabbia e pietrisco tra suolo e struttura o anche sistemi di rulli interposti fra fondazione e sovrastruttura che ne permettessero lo scorrimento, ma non fu seguita, preferendo la via della rigidezza e della resistenza, ossia quella di progettare edifici incastrati alla base, imponendo severe limitazioni in altezza e tenendo conto degli effetti del sisma attraverso una certa azione orizzontale.

Al contrario, Frank Lloyd Wright progettò l’Imperial Hotel a Tokyo, la cui costruzione fu completata nel 1921, prevedendo fondazioni su uno strato di terreno compatto, spesso poco più di 2 m, che a sua volta poggiava su uno strato di limi melmosi, profondo circa 20 m. Questo comodo cuscino filtrò le componenti del sisma di periodo breve, trasmettendo in superficie solo componenti di periodo lungo, salvando la struttura dal terremoto che investì Tokyo nel 1923

e che causò il crollo di molti edifici progettati con tecniche tradizionali.

La prima applicazione moderna dell’isolamento sismico è quella della scuola Pestolazzi di Skopje in Macedonia, ricostruita a seguito di un sisma nel 1960. Il sistema di isolamento, proposto da un team di ingegneri svizzeri e denominato Swiss Full Base Isolation 3D, rappresenta il prototipo degli attuali dispositivi elastomerici.

Con la costruzione di impianti nucleari si rese indispensabile l’adozione di sistemi di protezione sismica di massima sicurezza e affidabilità. È in quest’ottica che nascono le prime applicazioni dell’era moderna dell’isolamento sismico.

Il metodo deduttivo e quello induttivo

Alla base di tale rivoluzione c’è il ruolo della Chimica rispetto ai due metodi per acquisire la conoscenza:

? il metodo deduttivo basato sulla conoscenza a priori ? sorgente della verità (Platone, Hegel) ? di certezze assolute (idee) e di presupposti non discutibili (assunzioni), sulle sue elaborazioni (Aristotele, Cartesio, Kant), sfociato al XX secolo in filosofie molto diverse (individualismo di Nietsche e esistenzialismo di Heidegger) con la negazione di qualsiasi conoscenza non assiomatica e degli assoluti universali;

? il metodo induttivo di Bacone: I dati come conoscenza oggettiva e registrata, che può essere acquisita da ciascuno; la teoria deve essere confermata ed allora rappresenta la certezza assoluta, di cui l’utilitarismo ed empirismo di Husne, il neopositivismo di Mach, il positivismo logico di Wittgesntein, l’evidenzialismo di Shaeffer con la persuasione dovuta alla evidenza, rappresentano la metodologia di pensiero.

In fondo bene considerando la chimica, dalle origini e per molti anni, fu fortemente analitica, impegnata nell’acquisizione di conoscenze sul mondo inorganico e poi su quello organico, sulla composizione della materia e sulla sua struttura, infine sui processi che si determinano nei sistemi indagati.

Quando il bagaglio di conoscenza, fu notevole, fu possibile trarne vantaggi economici per l’uomo, in termini di merci migliori e in maggiori quantità, di tutela della salute pubblica, di benessere generalizzato; allora il ruolo euristico decadde per trasformarsi in quello di tutore per la conservazione di quello stato favorevole di cose; ci fu la tendenza a relegare l’analisi a un ruolo ancillare, a un servizio indispensabile di struttura solida ma statica. Da un certo tempo, questa stortura si va sanando e si va di nuovo sviluppando la ricerca analitica conoscitiva rivolta ai fenomeni di base, ai problemi nuovi e reali, alla ottimizzazione e alle gestione economica dei processi produttivi, allo sviluppo dei mezzi strumentali di indagine adeguati e alla apertura di nuovi capitoli.

Questo dilemma è l’espressione di un altro, che ha da sempre scosso la scienza, quello cioè fra metodo deduttivo e metodo induttivo, fra semplice teoria e sperimentazione. Ci sono voluti molti anni per comprendere che il valore aggiunto di un’esperienza nuova non è certo inferiore a quello di una teoria elaborata sulla base di principi e leggi generali o di esperienze condotte ed elaborate da altri.

Fondazione ITS, Istituto tecnico superiore Agroalimentare Puglia, Locorotondo (Ba)

La Fondazione si propone, attraverso una strategia formativa mirata, di trasferire le innovazioni al settore agroalimentare, favorendo l’innalzamento del capitale umano al fine dello sviluppo dell’intero sistema-territorio. Opera sulla base di piani triennali con l’obiettivo di assicurare, con continuità, l’offerta di tecnici superiori a livello post-secondario in relazione a figure che rispondano alla domanda proveniente dal mondo del lavoro. Infine, in relazione alle priorità strategiche per lo sviluppo economico del Paese e della programmazione regionale, la Fondazione conduce attività di studio, ricerca, progettazione, informazione e formazione per il sistema agroalimentare.

La Puglia fra Seicento e Settecento

La Puglia, ancora oggi è attraversata da braccianti agricoli, assunti a giornata, che si spostano, anche di molte decine di chilometri, per andare a lavorare nei campi. Nel passato i flussi partivano da distanze ancora più grandi e c’era chi percorreva il territorio regionale andando da un estremo all’altro. Un trasferimento che comportava faticose e a volte anche tremende condizioni di viaggio. Oggi molti migranti, provenienti da diverse zone del mondo economicamente sottosviluppato, percorrono, con un elevato rischio di morte, grandi distanze per arrivare in Italia e poi continuano a camminare per andare a lavorare nei campi ai quali vengono destinati.

In Puglia, fra Seicento e Settecento, i braccianti (figli o capofamiglia) trascorrevano intere stagioni lontano dalla loro casa e, nelle zone più malsane come quelle della Capitanata, erano in molti a morire per infezioni di ogni tipo. Attraverso la documentazione di origine religiosa e di origine civile (raccolta in Archivi ecclesiastici, di Stato o privati, come registrazioni di battesimo e di sepoltura, atti di matrimonio…) è possibile ricostruire una storia dei braccianti pugliesi, di quelli che andavano verso Nord, in Capitanata, per raccogliere il grano e di quelli che andavano invece verso Sud per la zappatura delle vigne nel Salento.

Fra fine Seicento e primo Ottocento si può rilevare un’accentuata instabilità della popolazione agricola in tutto il Regno di Napoli. Il carattere saltuario del lavoro bracciantile, costringeva i lavoratori a giornata ad accorrere nelle zone nelle quali l’impiego della loro opera poteva essere assicurato per un più lungo periodo di tempo. Nelle fasi di punta del raccolto e della lavorazione dei prodotti più diffusi (grano, olio e vino, che costituivano una risorsa alimentare fondamentale per tutto il Regno), la manodopera nelle zone di maggiore produzione era insufficiente e non pochi territori ne restavano sprovvisti con gravi conseguenze. Quindi correnti di salariati, braccianti, pastori e, in parte molto limitata, di artigiani, percorrevano in lungo e in largo ampi spazi per vendere il proprio lavoro.

In ognuna delle fasi storiche fra 600 e 800, i movimenti migratori attraversavano «come un filo rosso» la storia moderna delle province meridionali presentandosi con caratteristiche anche diverse (sia per gli aspetti economici dei flussi di individui che di volta in volta si spostavano, sia per le problematiche sociali sorte intorno ad essi).

– Quando si vietò l’emigrazione degli abruzzesi nel Lazio

Giovanna Da Molin, Professore Ordinario di Demografia Storica e Sociale, Dipartimento di Scienze della Formazione, Psicologia, Comunicazione; Università degli Studi di Bari «Aldo Moro»

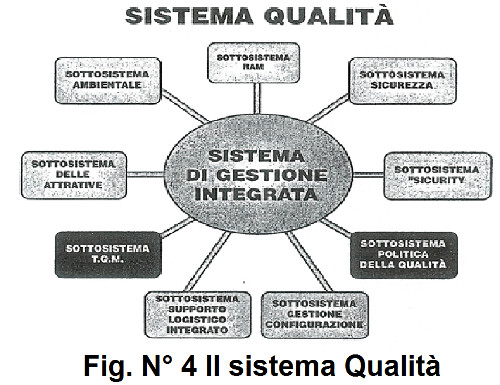

Safety e Security

I rischi di carattere strettamente connessi a tutti i sistemi siano essi semplici e/o complessi, quali ad esempio le centrali nucleari, provengono normalmente da problemi di insicurezza in senso generale. La società moderna è immersa in campi di informazioni, di comunicazioni, di poteri di ogni genere, economici, energetici, ecologici, giuridici e, in genere cibernetici che condizionano giornalmente la vita di ogni cittadino (Fig. N° 1). I popoli evoluti però, ben sanno che alla base della vita moderna prevale il concetto di accettabilità del rischio connesso ad una vita standard fatto di rischi prodotti da cibi biologici non sempre naturali, da automobili veloci, da treni veloci, da fattori ambientali assoggettati ai cambiamenti climatici, da aerei supersonici e via discorrendo. La maggioranza di questo tipo di Società del Rischio accetta il rischio intrinseco all’uso, ad esempio, di questi mezzi di trasporto poiché li ritiene sufficientemente sicuri e confortevoli.

I rischi di carattere strettamente connessi a tutti i sistemi siano essi semplici e/o complessi, quali ad esempio le centrali nucleari, provengono normalmente da problemi di insicurezza in senso generale. La società moderna è immersa in campi di informazioni, di comunicazioni, di poteri di ogni genere, economici, energetici, ecologici, giuridici e, in genere cibernetici che condizionano giornalmente la vita di ogni cittadino (Fig. N° 1). I popoli evoluti però, ben sanno che alla base della vita moderna prevale il concetto di accettabilità del rischio connesso ad una vita standard fatto di rischi prodotti da cibi biologici non sempre naturali, da automobili veloci, da treni veloci, da fattori ambientali assoggettati ai cambiamenti climatici, da aerei supersonici e via discorrendo. La maggioranza di questo tipo di Società del Rischio accetta il rischio intrinseco all’uso, ad esempio, di questi mezzi di trasporto poiché li ritiene sufficientemente sicuri e confortevoli.

Nella letteratura scientifica anglosassone si usa distinguere fra «safety» nel senso di progettazione della sicurezza (probabilità di funzionamento sicuro del sistema) e «security» ossia la protezione della proprietà del sistema da furti, rapine, intrusioni, tentativi di boicottaggio, sabotaggio, terrorismo ecc. Recentemente (Giuseppe Quartieri, Introduzione alla Sicurezza di Sistemi Nucleari, 2010), si è introdotto il concetto di «risk society», la Società del Rischio (Fig. N° 1).

La distinzione, la interfaccia e le interrelazioni fra «safety» e «security» sono mostrate nella Fig. N° 2 applicando la teoria degli insiemi.

II problemi e le soluzioni adottate per il raggiungimento della massima sicurezza dei grandi sistemi complessi di cui le centrali nucleari sono solo un esempio, tra i più eclatanti, del grande lavoro che va eseguito per allargare la conoscenza della nozione di sicurezza ai lettori. Anzi, si continua, con perseveranza, in questa linea solo nella speranza di qualche loro suggerimento al fine di pervenire a miglioramenti qualitativi che rendano la sicurezza sempre più stabile a garanzia di ogni evenienza.

A dispetto dell’omnicomprensivo italico concetto di sicurezza va ricordato come su accennato, per meglio rendere l’idea sul concetto della cautela dai pericoli del nucleare che tanto preoccupa gli ortodossi della ecologia, che vi sono due aspetti fondamentali della sicurezza: la «safety» e la «security». Come già detto, nella lingua anglosassone esistono queste due parole per distinguere fra il concetto di sicurezza intrinseca (safety) di natura tecnologica prodotta da guasti del sistema complesso (centrale nucleare, aereo, missile, satellite ecc.) e/o da errori umani con effetti negativi per la salute del personale addetto o della popolazione circostante e conseguente perdita di proprietà. Gli anglosassoni impiegano invece la parola «security» per intendere la sicurezza in termini di protezione da infrazioni varie, intrusione, criminalità, sabotaggi e terrorismo di ogni tipo. Nella nostra lingua esiste solo la parola «sicurezza» che include tutti gli aspetti possibili ed è quindi «omnicomprensiva».

Questa insistenza sul significato del temine usato, stante l’attuale clima di guerra fredda contro il pericolo che il nucleare possa risorgere, come l’«Araba fenice», in Italia dal rogo dei due referendum, non è vano poiché si presta a generare ben altri tipi di problemi e incomprensioni nella visione popolare della sicurezza delle centrali nucleari. Pertanto, da alcuni punti di vista (soprattutto politici) la questione andrebbe esaminata in modo completo, includendo tutti gli aspetti con approccio per sistemi o sistemico.

Alla stessa stregua il popolo accetta di impiegare energia elettrica proveniente da centrali termiche alimentate a petrolio oppure a gas metano nonostante i sinistri e i guasti catastrofici come la «Marea Nera» oppure i vari incidenti accaduti nelle miniere di produzione di gas e di petrolio in tutto il mondo.

Gli Italiani, come quasi tutti i popoli della Terra, accettano l’inquinamento prodotto dai gas di scarico delle automobili (polveri sottili, benzene, ossidi di carbonio, PM10, PM2,5 e anche PM1 ecc.) nel centro delle grandi città, nella pianura Padana e vicino alle centrali a combustibili fossili ecc. Così facendo il popolo italiano dimentica o fa finta di dimenticare le conseguenze serie dell’inquinamento cittadino che produce secondo le analisi e le statistiche, ormai accertate, una quantità consistente di esempi di «cancerogenesi».